//AMD发布会:“最强算力”Instinct MI300X、新款AI PC芯片如期登场//

当地时间周三,AMD举行“Advancing AI”发布会,除了如期发布诸如Instinct MI300X、MI300A、锐龙8040系列处理器等外,大量AI产业的龙头公司也来到现场,为“英伟达挑战者”站台助威。

(来源:AMD)

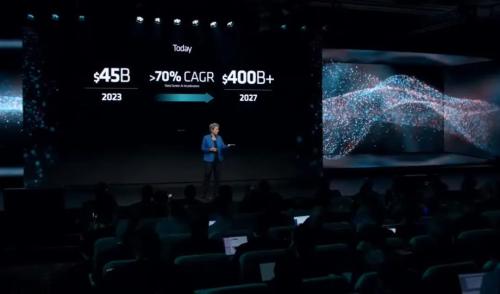

在开场发言中,苏姿丰博士就甩出了一组令股民们极为兴奋的数据:一年前AMD曾预期,数据中心加速器的市场规模,大概能从2023年的300亿美元倍增至2027年的1500亿美元。而到了今天,AMD将2027年的市场规模预期猛然上修至4000亿美元,对应70%的年化复合增长率。

接下来就是介绍硬件的部分了。

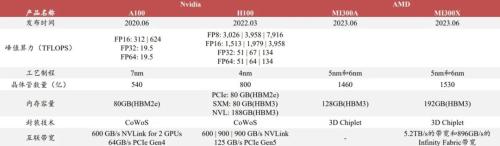

首先登场的是Instinct MI300X加速器,由于MI300系列芯片的参数半年前就已经公布过,所以今天的发布会更多聚焦于整套系统在实际应用中的表现。

(芯片参数,来源:中泰证券研报)

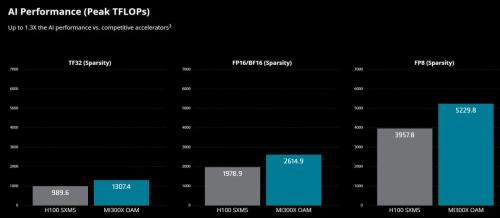

Instinct MI300X加速器由8个MI300X组成,能够提供高达1.5TB的HBM3内存容量。与Instinct MI250X相比,MI300X系统计算单元多出了接近40%,还有1.5倍的内存容量,以及1.7倍的峰值理论内存带宽。同时新系统也支持FP8、稀疏性等更多的数学格式。

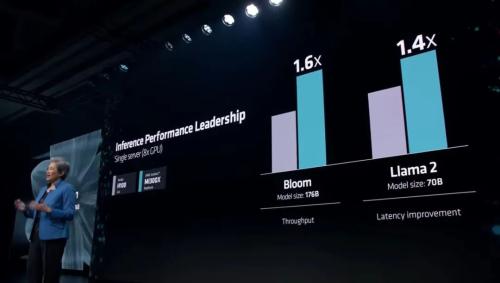

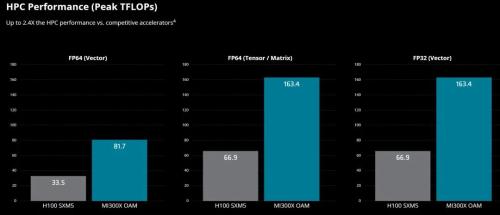

当然,更重要的是与英伟达的对比。AMD表示,与H100 HGX相比,Instinct MI300X加速器在运行大语言模型推理时的吞吐量和时延表现要明显高出一截,在各项AI和HPC项目中也明显要高出一头。

苏姿丰也在周三宣布,Instinct MI300X加速器已经从今天开始发货,与此同时,Instinct MI300A加速器也已经进入了量产阶段。

Instinct MI300A是世界首款专为HPC和AI设计的APU,使用的HBM3内存规格为128GB。与Instinct MI250X相比,MI300A的性能功耗比能接近翻番。

正如开头所提,今天的发布会也有众多友商前来捧场,当然也都不是空手而来的。

微软CTO凯文·斯科特在现场宣布,从今天开始,Azure云将开放Instinct MI300X虚拟机的预览。OpenAI也宣布,该公司开发的GPU编程语言Triton,将从接下来的3.0版本开始支持MI300等AMD芯片。Meta、甲骨文的高管当场表示,将在自己的AI和数据中心服务中使用Instinct MI300X加速器。

值得一提的是,除了硬件规格的提升,AMD也在周三宣布了最新版本的ROCm 6开源软件平台。公司介绍称,ROCm 6在提升AI加速性能方面取得了显著进步,特别是在MI300系列加速器上运行Llama 2文本生成任务时,其AI加速性能比前一代硬件和软件提高了大约8倍。

AI PC也有新产品

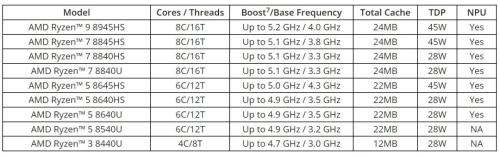

除了数据中心级别的芯片外,AMD也在周三发布了锐龙8040系列移动处理器。AMD介绍称,与上一代同样搭载锐龙AI NPU的7040相比,8040系列在AI任务展现了进一步的提升。

AMD介绍称,整个系列总共有9款芯片,预计搭载该系列的电脑将从2024年一季度开始发售。

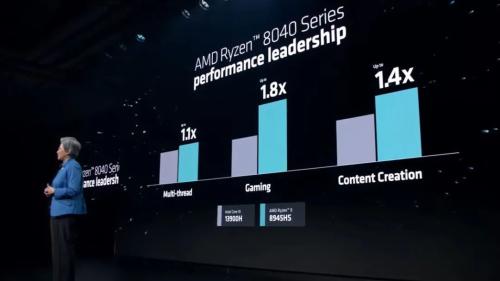

当然作为这两年苹果、AMD的保留节目,在与英特尔的旗舰移动处理器i9-13900H的对比中,AMD的8945HS在多项指标的比较中出现大幅领先的情况。

值得一提的是,虽然发布会本身符合预期,但对AMD的股价并未构成提振作用。在周三科技股集体走弱的背景下,AMD发布会还没开完,股价就由涨转跌,最终收跌超1%。

//谷歌最强AI模型Gemini正式发布:多模态、三大版本//

当地时间周三,美国科技巨头谷歌宣布推出其认为规模最大、功能最强大的人工智能模型Gemini,这种技术能够处理视频、音频和文本等不同内容形式的信息。

谷歌表示,该公司备受期待的人工智能模型名为Gemini,对比之前的技术,能够进行更复杂的推理,理解更加细微的信息。它通过阅读、过滤和理解信息,可以从数十万份文件中提取要点,将有助于在从科学到金融的许多领域实现新的突破。

谷歌首席执行官桑达尔·皮查伊在一篇博文中写道:“这个新模型代表了我们作为一家科技公司所做的最大的科学和工程努力之一,它也是一个多模态基础模型,可以概括和理解不同类型的信息,包括文本、代码、音频、图像和视频。”

自OpenAI一年前推出ChatGPT以来,谷歌一直在努力开发能够与这家公司相抗衡的人工智能软件。谷歌声称,已经在其人工智能助手Bard上添加了部分Gemini模型的技术,并表示计划在明年年初将最先进的Gemini模型完全融入到Bard中。

谷歌高管们认为,Gemini Pro的表现优于GPT-3.5,但回避了与GPT-4相比如何的问题。而在今年3月,OpenAI推出了GPT-4。

这家科技公司表示,将发布三种版本的Gemini,分别为Gemini Ultra、Gemini Pro和Gemini Nano。每个版本具有不同的信息处理能力,功能最强大的Gemini Ultra版本是为在数据中心运行而设计的,最弱的Gemini Nano版本将在移动设备上高效运行。

从12月13日开始,开发者和企业客户可以通过Google AI Studio或Google Cloud Vertex AI中的Gemini API访问Gemini Pro。Android开发者也可以使用Gemini Nano进行软件开发。

DeepMind负责产品的副总裁Eli Collins声称,Gemini是谷歌DeepMind人工智能部门帮助创造的最强大的人工智能模型,但与该公司之前的大模型相比,它为用户提供的服务“明显”更加便宜。

Collins补充说:“因此,Gemini不仅功能更强,效率也高得多。最新的模型仍然需要大量的计算能力来训练,谷歌正在快速推进这一过程。”

谷歌还发布了其最强大的人工智能芯片Cloud TPU v5p,它是在之前的版本基础上进行的改进。根据谷歌的说法,与TPU v4相比,TPU v5p的浮点运算性能提升了两倍,它训练大语言模型的速度比TPU v4快2.8倍。